04 Mai 02.05.2023

Künstliche Intelligenz: Verstehen natürlicher Sprache als Herausforderung internationaler Forschung

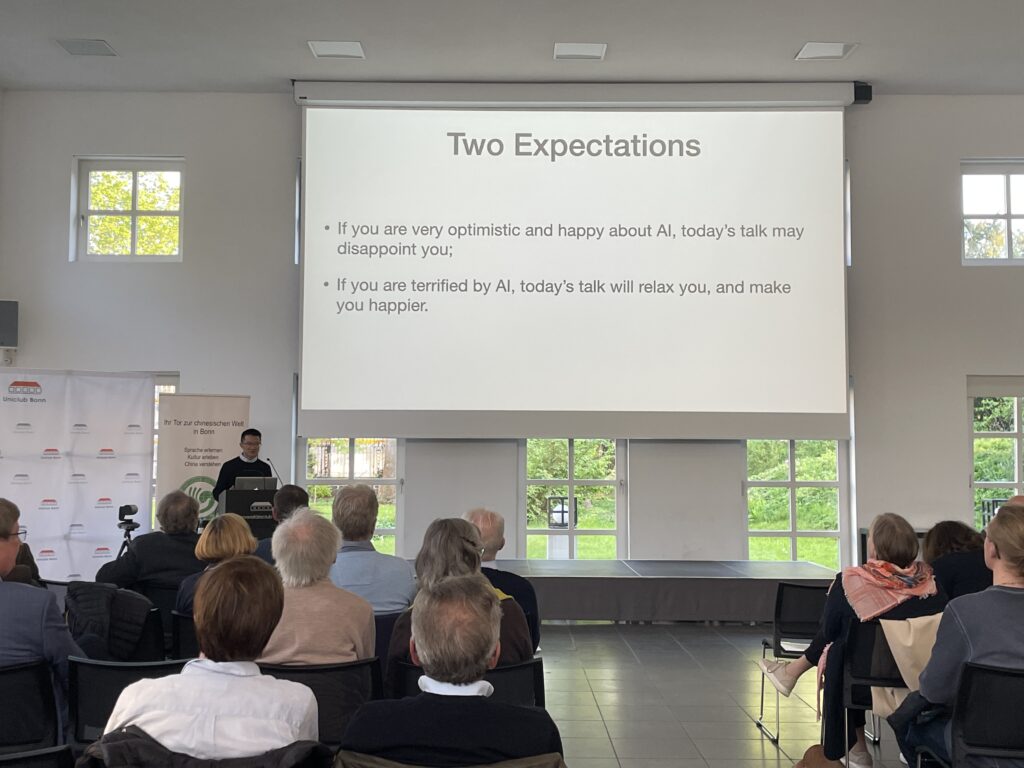

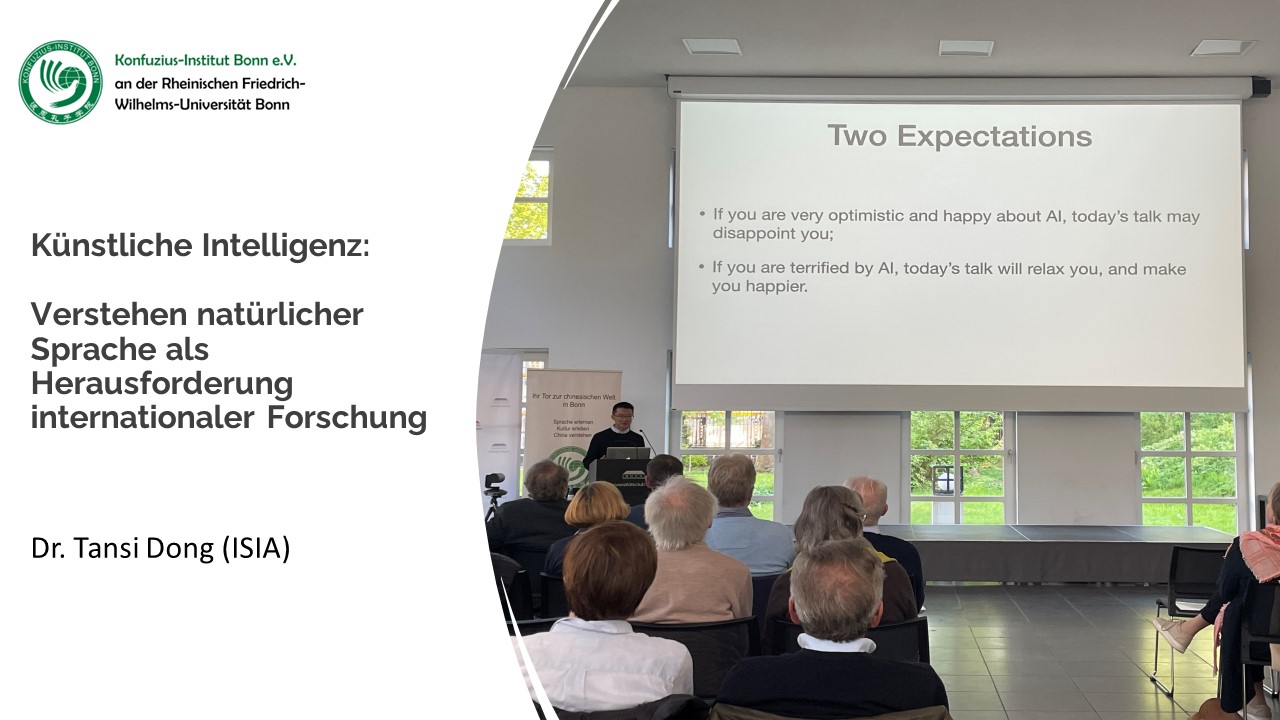

Am 02. Mai fand im Bonner Uniclub eine Kooperationsveranstaltung zum Thema „Künstliche Intelligenz: Verstehen natürlicher Sprache als Herausforderung internationaler Forschung“ statt. Prof. Günther Schulz und Prof. Armin Cremers begrüßten die Zuschauer einführend. In den Eingangsbemerkungen ging es auch um das Unbehagen und die Irritation, die das Thema Künstliche Intelligenz bei vielen Menschen auslöst. So sind z.B. Fragen nach dem Urheberrecht sind heute noch nicht geklärt und Prof. Cremers warf die Frage auf, ob Chat GPT als Autor in wissenschaftlichen Publikationen aufgeführt oder zumindest auf dessen Gebrauch verwiesen werden sollte.

Im Hauptvortrag von Dr. Tiansi DONG ging es anschließend um aktuelle Forschung in Bezug auf KI – insbesondere natürliche Sprachverarbeitung und Wahrnehmung von Raum.

Denn räumliches Denken zeigt sich in der Art und Weise, wie wir denken, und in der Art und Weise, wie wir Gedanken durch Handlungen und Sprache externalisieren; Im Gegenzug sind Sprachen Fenster, um räumliches Denken zu erforschen. Räumliche Wahrnehmung ist eine grundlegende Fähigkeit für alle Lebewesen und Grundlage für das abstrakte Denken des Menschen. Die Philosophie des räumlichen Denkens fordert den computergestützten Ansatz zur Verarbeitung und zum Verständnis natürlicher Sprache heraus. Eine Automatisierung von „Natural Language Understanding“ (NLU) als Leistung Künstlicher Intelligenz (KI) ist besonders anspruchsvoll, da die Begründung selbst elementarer Kategorienbeziehungen erfordert, dass die Maschine über die Verarbeitung von Zeichenfolgen hinausgeht, um eine semantische Ebene zu erreichen und zu einem räumlichen Modell zu gelangen.

Jüngste Entwicklungen des neuronalen Computing realisieren das „Verstehen“ natürlicher Sprache, indem Wörter als Punkte eines hochdimensionalen Vektorraums dargestellt und Textzusammenhänge geometrisch modelliert und maschinell gelernt werden, so dass Fortsetzungen einer sprachlichen Eingabe im Kontext gezielt auf einer statistischen Basis vorhergesagt werden können. Seit kurzem sind Aufsehen erregende Erfolge amerikanischer KI-Systeme wie z.B. ChatGPT und BERT zu verzeichnen, die in weit verbreitete Suchmaschinen integriert worden sind. Wu-Dao, Chinas erstes selbst entwickeltes „intelligentes Super-Scale“-Modellsystem, das sich programmatisch aus kognitiver Sicht auf allgemeine künstliche Intelligenz konzentriert, hat BERT beim SuperGLUE-Benchmark zum Verstehen natürlicher Sprache deutlich übertroffen. ChatGLM, der Nachfolger von Wu-Dao, ist Chinas Herausforderer von ChatGPT. Eine Entscheidung dieses technologischen Wettbewerbs steht noch aus.

Unsere Experimente zeigen, dass z.B. ChatGPT die Bedeutung von Sprache nicht wirklich versteht, nicht einmal die grundlegenden Kategorienbeziehungen zwischen Wörtern, obwohl es so scheint. Wir schreiben diese Einschränkung dem Repräsentationsproblem zu: Da es kognitiv unzulänglich erscheint, alles als Punkte darzustellen, müssen wir vielmehr Punkte zu Regionen aufblasen und, bildlich gesprochen, den neuronalen Netzen Raum zur Entfaltung geben.

Wir schließen mit einem Ausblick auf räumlichen Humor. Kinder genießen Comics lange bevor sie sprechen können; Humor ist dem räumlichen Denken verwandt. Ein ausgereiftes KI-Grundlagenmodell muss in der Lage sein, Witze (als eine Form von Humor) auf einfache Weise zu „verstehen“, was jedoch bisher alle monolithischen KI-Ansätze (symbolisch, statistisch, neuronal) frustriert hat. Auch hier ist ein neurosymbolischer Ansatz vielversprechend, indem symbolische Strukturen auf dem Raum verankert werden, der durch neuronales Computing aufgespannt wird.